Puesto que los estimadores de las varianzas consistentes con heteroscedasticidad de White están disponibles ahora en paquetes de regresión, se recomienda que el lector les reporte.

Busca en el Blog

miércoles, 31 de diciembre de 2014

Varianzas y errores estándar consistentes con heteroscedasticidad de White. (II)

Puesto que los estimadores de las varianzas consistentes con heteroscedasticidad de White están disponibles ahora en paquetes de regresión, se recomienda que el lector les reporte.

martes, 30 de diciembre de 2014

Varianzas y errores estándar consistentes con heteroscedasticidad de White. (I)

donde Y = gasto pér capita en colegios públicos por estado en 1979 e Ingreso = ingreso per cápita por estado en 1979. La muestra consistió en 50 estados más Washington, D.C.

lunes, 29 de diciembre de 2014

Cuando σi² es no conocida

domingo, 28 de diciembre de 2014

Ejemplo Ilustración del Método de mínimos cuadrados ponderados (II)

sábado, 27 de diciembre de 2014

Ejemplo Ilustración del Método de mínimos cuadrados ponderados (I)

Ahora sea Y la compensación salarial promedio por empleado (US$) y X el tamaño de empleo, se efectúa la siguiente regresión

viernes, 26 de diciembre de 2014

Cuando σi² es conocida: Método de mínimos cuadrados ponderados

jueves, 25 de diciembre de 2014

Medidas Remediales

miércoles, 24 de diciembre de 2014

Otras pruebas de heteroscedasticidad

martes, 23 de diciembre de 2014

Ejemplo Prueba de heteroscedasticidad de White (III)

lunes, 22 de diciembre de 2014

Ejemplo Prueba de heteroscedasticidad de White (II)

domingo, 21 de diciembre de 2014

Ejemplo Prueba de heteroscedasticidad de White (I)

lnYi = β1 + β2lnX2i +β3linX3i +ui

donde Y = razón entre impuestos arencelarios (impuestos sobre importaciones y exportaciones) y recaudos totales de gobierno, X2 = razón entre la suma de exportaciones e importaciones y el PNB y X3 = PNB per cápita: y ln representa el logaritmo natural. Sus hpótesis fueron que Y y X2 estarían relacionadas positivamente (a mayor volumen de comercio exterior, mayor recaudo arencelario) y que Y y X3 estarían negativamente relacionados (a medida que aumenta el ingreso, el gobierno encuentra más sencillo recolectar impuestos directos- es decir, el impuesto sobre la renta - que depende de los impuestos sobre el comercio exterior.)

sábado, 20 de diciembre de 2014

Prueba general e heteroscedasticidad de White (IV)

Paso 4.

Si el valor ji cuadrado obtenido en (11.5.22) excede al valor ji cuadrado crítico al nivel de significancia seleccionado, la conclusión es que hay heteroscedasticidad. Si éste no excede el valor ji cuadrado crítico, no hay heteroscedasticidad, lo cual quiere decir que en la regresión auxiliar (11.5.21), α2 =α3 = α4 = α5 = α6 = 0.viernes, 19 de diciembre de 2014

Prueba general e heteroscedasticidad de White (III)

Bajo la hipótesis nula de que no hay heteroscedasticidad, puede demostrarse que el tamaño de la muestra (n) multiplicado por el R², obtenido de la regresión auxiliar asintóticamente sigue la distribución ji-cuadrado con g de 1 igual al numero de regresores (excluyendo el término constante) en la regresión auxiliar es decir:

donde los g de l son iguales a los definidos anteriormente. En nuestro ejemplo, hay 5 g de l puesto que hay 5 regresores en la regresión auxiliar.

jueves, 18 de diciembre de 2014

Prueba general e heteroscedasticidad de White (II)

Paso 1. Dada la información, estímese (11.5.20) y obténgase los residuales ûi.

Paso 2. Efectúese la siguiente regresión (auxiliar):

miércoles, 17 de diciembre de 2014

Prueba general e heteroscedasticidad de White (I)

martes, 16 de diciembre de 2014

Ejemplo la prueba de Breusch- Pagan-Godfrey (II)

lunes, 15 de diciembre de 2014

Ejemplo la prueba de Breusch- Pagan-Godfrey (I)

domingo, 14 de diciembre de 2014

Prueba de Breusch-Pagan-Godfrey

Para ilustrar esta prueba, considérese el modelo de regresión lineal con k variables

sábado, 13 de diciembre de 2014

Ejemplo La prueba de Goldfeld-Quandt (II)

viernes, 12 de diciembre de 2014

Ejemplo La prueba de Goldfeld-Quandt (I)

Eliminando las 4 observaciones de la mitad, las regresiones MCO basadas en las primeras 13 observaciones y en las últimas 13, y sus sumas de residuales al cuadrado asociadas se presentan a continuación (los errores estándar se indican entre paréntesis).

Regresión basada en las primeras 13 observaciones

jueves, 11 de diciembre de 2014

Incorporación de la técnica de la cota superior (III)

Antes de ilustra la prueba, conviene dar alguna explicación sobre la omisión de las observaciones centrales c. Estas observaciones son omitidas para agudizar o acentuar la diferencia entre el grupo de varianza pequeña (es decir, SRC1) y el grupo de varianza grande (es decir, SRC2). Pero la capacidad de la prueba de Goldfeld-Quandt para hacer esto exitosamente depende de la forma como c sea seleccionada. Para el modelo con dos variables, los experimentos de Monte Carlo realizados por Goldfeld y Quandt sugieren que es alrededor de 8 si el tamaño de la muestra alrededor de 30 y es alrededor de 16 si el tamaño de la muestra es alrededor de 60. Sin embargo, Judge et al, han encontrado satisfactorios en la práctica los niveles de c = 4 si n=30 y c = 10 si n es alrededor de 60.

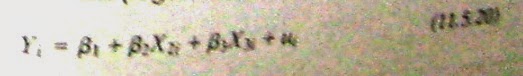

Antes de proseguir, puede mencionarse que en caso de que haya más de una variable X en el modelo, el ordenamiento de las observaciones, que es el primer paso en la prueba, puede adelantarse de acuerdo con cualquiera de ellas. Por tanto, en el modelo: Yi = β1

miércoles, 10 de diciembre de 2014

Prueba de Goldfeld-Quandt (II)

martes, 9 de diciembre de 2014

Prueba de Goldfeld-Quandt (I)

El supuesto (11.5.9) postula que σi² es proporcional al cuadrado de la variable X. En su estudio presupuestos familiares, Prais y Houthakker han encontrado bastante útil ese supuesto.

lunes, 8 de diciembre de 2014

domingo, 7 de diciembre de 2014

Ejemplo Ilustración de la prueba de correlación por rango

Aplicando la fórmula (11.5.5), se puede obtener

sábado, 6 de diciembre de 2014

Prueba de correlación por grado de Spearman (II)

viernes, 5 de diciembre de 2014

jueves, 4 de diciembre de 2014

Prueba de Glejser (II)

no son lineales en los parámetros y, por consiguiente, no pueden ser estimados mediante el procedimiento MCO usual.

Glejser ha encontrado que para muestras grandes, los cuatro primeros modelos anteriores generalmente dan resultados satisfactorios en la detección de la heteroscedasticidad. En la práctica, por consiguiente, la técnica de Glejser puede ser utilizada para muestras grandes y en muestras pequeñas pueden ser utilizada escrictamente como herramienta cualitativa para obtener una noción sobre la heteroscedasticidad. Para una aplicación del método de Glejser, véase...

miércoles, 3 de diciembre de 2014

Prueba de Glejser (I)

donde vi es el término de error

martes, 2 de diciembre de 2014

Ejemplo Relación entre compensación salarial y productividad (II)

Los residuales obtenidos de la regresión (11.5.3) fueron regresados sobre Xi como lo sugiere la ecuación (11.5.2), dando los siguientes resultados:

lunes, 1 de diciembre de 2014

Ejemplo Relación entre compensación salarial y productividad (I)

Yi = β1+ β2Xi + ui

donde Y = compensación promedio en miles de dólares, X = productividad promedio en miles de dólares e i = iésimo tamaño de empleo del establecimiento. Los resultados de la regresión fueron los siguientes:

domingo, 30 de noviembre de 2014

Métodos formales - Prueba de Park (II)

Si β resulta ser estadísticamente significativo, esto sugerirá que hay heteroscedasticidad en los datos. Si resulta ser no significativo, se puede aceptar el supuesto de heteroscedasticidad. La prueba de Park es, por tanto, un procedimiento de dos etapas. En la primera etapa se efectúa la regresión MCO ignorando el interrogante de la heteroscedasticidad. Se obtiene ûi de esta regresión y luego, en la segunda etapa, se efectúa la regresión (11.5.2).

Aunque empíricamente la prueba de Park es atractiva, ésta tiene algunos problemas. Goldfeld y Quandt han argumentado que el término de error vi que entra en (11.5.2) puede no satisfacer los supuestos MCO y puede en sí mismo ser heteroscedástico. No obstante, es posible utilizar la prueba de Park como un método esctrictamente exploratorio.

sábado, 29 de noviembre de 2014

Métodos formales - Prueba de Park (I)

viernes, 28 de noviembre de 2014

Método gráfico (II)

jueves, 27 de noviembre de 2014

Método gráfico (I)

En la figura 11.7 se grafican los ûi² frente a los Yi, que son los Yi estimados mediante la línea de regresión, con la idea de averiguar si el valor medio estimado de Y está relacionado sistemáticamente con el residual al cuadrado. En la figura 11.7a se ve que no hay patrón sistemático entre las dosvariables, lo cual sugiere que posiblemente no hay heteroscedasticidad en los datos. Sin embargo las figuras 11.7b hasta 11.7e muestran patrones definidos. Por ejemplo, la figura 11.7c sugiere una relación lineal, mientras que las figuras 11.7 y 11.7e indican una relación cuadrática entre ûi² y Yi. Utilizando tal conocimiento, si bien es informal, es posible transformar los datos de tal manera que una vez transformados, no presenten heteroscedasticidad. En la sección 11.6 se examinarán diversas transformaciones de este tipo.

miércoles, 26 de noviembre de 2014

Métodos informales

martes, 25 de noviembre de 2014

Detección de la heteroscedasticidad

Teniendo en mente la advertencia anterior, se pueden examinar algunos de los métodos informales y formales para detectar la heteroscedasticidad. Como lo revelará el siguiente análisis, la mayoría de estos métodos están basados en el examen de los residuales ûi de MCO, puesto que son estos los que se observan y no las perturbaciones ui. Se espera que ellos sean buenas estimaciones de ui. una esperanza que puede cumplirse si el tamaño de la muestra es relativamente grande.

lunes, 24 de noviembre de 2014

Estimación MCO ignorando la heteroscedasticidad (III)

DEl análisis anterior, es claro que la hetorscedasticidad es un problema potencialmente grave y el investigador debe saber si ella está presente en una situación dada. Si se detecta su presencia, se pueden tomar acciones correctivas, tales como utilizar una regresión de mínimos cuadrados ponderados o alguna otra técnica. Sin embargo, antes de examinar los diversos procedimientos correctivos, es preciso averiguar primero si hay presencia de heteroscedasticidad o si es probable que la haya en un caso dado. Este tema se analiza en la siguiente sección.

domingo, 23 de noviembre de 2014

Estimación MCO ignorando la heteroscedasticidad (II)

Yi = β1+β2Xi +ui

Suponen que β1=1, β2 = 2 y ui ~N(0,Xi^α) Como lo indica la última expresión, ellos suponen que la varianza del error es heteroscedástica y que está relacionada con el valor del regresor X elevado a la potencia α. Si, por ejemplo, α =1, la varianza del error es proporcional al valor de Xi si α =2, la varianza del error es proporcional al cuadrado del valor de X y así sucesivamente. En la sección 11.6 se considerará la lógica que soporta tal procedimiento. Basados en 20,000 replicaciones y permitiendo diversos valores para α, ellos obtienen los errores estándar de los dos coeficientes de regresión utilizando MCO. MCO con presencia de heteroscedasticidad y MCG. Se citan sus resultados para valores seleccionados de α:

sábado, 22 de noviembre de 2014

EStimación MCO ignorando la heteroscedasticidad (I)

viernes, 21 de noviembre de 2014

Estimación MCO considerando la heteroscetasticidad

jueves, 20 de noviembre de 2014

Consecuencias de utilizar MCO en presencia de heteroscedasticidad

miércoles, 19 de noviembre de 2014

El método de mínimos cuadrados generalizados (MCG) (V)

Puesto que (11.3.11) miminiza un SRC ponderada, esto se conoce apropiadamente como mínimos cuadrados ponderados (MCP) y los estimadores así obtenidos que aparecen en (11.3.8) y (11.3.9) son conocidos como estimadores MCP. Pero MCP es apenas un caso especial de la técnica de estimación mas general, MCL. En el contexto de la heroscedasticidad, se pueden tratar los dos términos MCP y MCG indistintamente. En capítulos posteriores se presentarán otros casos especiales de MCG.

A propósito, obsévese que si wi= w es constante para todos los i, el β2* es idéntico al β2 y la var(β2) es idéntica a la var(β2) usual (es decir, homoscedástica) dada en (11.2.3), lo cual no debe sorprender (Por que?).

martes, 18 de noviembre de 2014

El método de mínimos cuadrados generalizados (MCG) (IV)

lunes, 17 de noviembre de 2014

El método de mínimos cuadrados generalizados (MCG) (III)

domingo, 16 de noviembre de 2014

El método de mínimos cuadrados generalizados (MCG) (II)

sábado, 15 de noviembre de 2014

El método de mínimos cuadrados generalizados (MCG) (I)

Desafortunadamente, el método MCO usual no sigue esta estrategia y , por consiguiente no hace uso de la "información" contenida en la variabilidad desigual de la variable dependiente Y, como es el caso de la compensación salarial de empleados de la figura 11.5. Este método asigna igual peso o importancia a cada observación. Pero existe un método de estimación, conocido como mínimos cuadrados generalizados (MCG), que tiene en cuenta esta información explícitamente y, por consiguiente, es capaz de producir estimadores que son MELI. Para ver la forma como esto se logra, considerese el modelo con dos variables ya familiar:

viernes, 14 de noviembre de 2014

Estimación MCO en presencia de Heteroscedasticidad (II)

Una vez se ha garantizado que β2 continúa siendo lineal e insesgado, sigue éste siendo "eficiente" o "el mejor", es decir, tendrá varianza mímina en la clase de los estimadores lineales e insesgados? y dicha varianza mínima estará dada por la ecuación (11.2.2)? La respuesta a ambas preguntas es no: β2 deja de ser el mejor y la varianza míinima ya no está dada por (11.2.2) Entonces, cuál estimador es MELI en presencia de heteroscedasticidad? La respuesta se da en la siguiente sección.

jueves, 13 de noviembre de 2014

Estimación MCO en presencia de Heteroscedasticidad (I)

miércoles, 12 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (IX)

martes, 11 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (VIII)

A manera de ilustración sobre la heteroscedasticidad que es posible encontrar en un análisis de corte transversal, considérese la tabla 11.1. Esta tabla presenta información sobre compensación salarial por empleado en 10 industrias de bienes manufacturados no durables, clasificadas según número de empleados de la empresa o establecimiento para el año 1958. En la tabla se presenta además cifras de productividad promedio para nueve clases de empleos.

lunes, 10 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (VII)

domingo, 9 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (VI)

4. La heterostacidad también puede surgir como resultado de la presencia de factores atípicos. Una observación o factor atípico es una observación que es muy diferente (o bien es muy pequeña o es muy grande) con relación a las demás observaciones en la muestra. La inclusión o exclusión de una observación de este tipo, especialemente si el tamaño de la muestra es pequeño, puede alterar sustancialmente los resultados del análisis de regresión. Como ejemplo, considérese el diagrama de dispersión dado en la figura 11.4. Con base en la información dada en el ejercicio 11.20, en esta figura se ha graficado la tasa de cambio porcentual de los precios de las acciones (Y) y los precios al consumidor (X) para el período posterior a la segunda guerra mundial hasta 19669 en 20 países. En esta figura, la observación sobre Y y X para Chile puede considerarse como atípica puesto que los valores Y y X son mucho más grandes que para el resto de los países. En situaciones como ésta, sería dificil mantener el supuesto de homoscedasticidad. En el ejercicio 11.20 se pide encontrar lo que sucede a los resultados de la regresión, si se retiran del análisis las observaciones de Chile.

sábado, 8 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (V)

viernes, 7 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (IV)

jueves, 6 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (III)

1. Con base en los Modelos de aprendizaje sobre errores, a medida que la gente aprende, con el tiempo, sus errores de comportamiento se hacen menores. en este caso, se espera que σi² se reduzca. Como ejemplo, considérese la figura 11.3,que relaciona el número de errores cometidos en una prueba de tiempo, establecida para la práctica de mecanografía durante un período de tiempo dado. Como lo indica la figura 11.3, a medida que aumenta el número de horas de esta práctica, el número promedio de errores de mecanografía se reduce al igual que sus varianzas.

miércoles, 5 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (II)

E(ui²) = σi²

Obsérvese el subídice de σ² que nos recuerda que las varianzas condicionales de ui (=varianzas condicionales de Yi) han dejado de ser constantes.

Para entender la diferencia entre homoscedasticidad y heteroscedasticidad, supóngase que en el modelo con dos variables Yi = β1+ β2Xi +ui, Y representa el ahorro y X representa el ingreso. Las figuras 11.1 y 11.2 indican que a medida que el ingreso aumenta, el ahorro en promedio también aumenta. Pero, en la figura 11.1, la varianza del ahorro permanece igual entodos los niveles de ingreso, mientras que, en la figura 11.2 ésta se incrementa con aumentos del ingreso. Parece que en la figura 11.2, en promedio, las familias de ingresos más altos ahorran más que las de ingresos más bajos, pero también hay más variabilidad en su ahorro.

martes, 4 de noviembre de 2014

Naturaleza de la Heteroscedasticidad (I)

E(ui²) = σ² i = 1,2,.....,n

Gráficamente,la homoscedasticidad en el modelo de regresión con dos variables puede ser observada en la figura 3.4, la cual, por conveniencia, se reproduce en la figura 11.1. Como lo indica esta figura, la varianza condicional de Yi (la cual es igual a la de ui), condicional a las Xi dadas, permanece igual sin importar los valores que tome la variable X.

lunes, 3 de noviembre de 2014

Heteroscedasticidad

Sin embargo, esto no significa que ella deba ser ignorada!

Un supuesto importante del modelo clásico de regresión lineal (supuesto 4) es que las perturbaciones ui que aparecen en la función de regresión poblacional son homoscedásticas; es decir todas tienen la misma varianza. En este capítulo se examina la validez de este supuesto y se analiza lo que sucede si éste no se cumple. Lo miso que en el capítulo 10 se buscan respuestas a las siguientes preguntas:

- Cuál es la naturaleza de la heteroscedasticidad?

- Cuáles son sus consecuencias?

- Cómo se detecta?

- Qué medidas remediales existen?

domingo, 2 de noviembre de 2014

Resumen y conclusiones Multicolinealidad y Muestras pequeñas (VI)

sábado, 1 de noviembre de 2014

Resumen y conclusiones Multicolinealidad y Muestras pequeñas (V)

5. Se mencionó aquí el papel de la multicolinealidad en la predicción y se señaló que a menos de que la estructura colineal continúe en la muestra futura, es peligroso utilizar una regresión estimada que haya sido contaminada por multicolinealidad para fines de proyección.

viernes, 31 de octubre de 2014

Resumen y conclusiones Multicolinealidad y Muestras pequeñas (IV)

d) Si R² es algo pero las correlaciones parciales son bajas, la multicolinealidad es una posiblidad. Aquí hay una o más variables que pueden ser superfluas. Pero si R² es alto las correlaciones parciales son altas también, la multicolinealidad puede no ser fácilmente detectable. También como lo señalan C. Robert, Krishna Kumar, John O'Hagan y Brendan Mc CAbe, hay algunos problemas estadísticos con la prueba correlación parcial sugerida por FArrar y Glauber.

e) Por consiguiente, se puede regresar cada una de las variables Xi sobre las variables X restantes en el modelo y encontrar los coeficientes de determinación correspondientes R²i. Un R²i elevado sugeriría que Xi está altamente correlacionado con el resto de las X. Así, se puede eliminar esta Xi del modelo, siempre y cuando conduzca a un sesgo de especificación grave.

jueves, 30 de octubre de 2014

Resumen y conclusiones Multicolinealidad y Muestras pequeñas (III)

a) El signo más claro de multicolinealidad es cuando el R² es muy alto, pero ninguno de los coeficientes de regresión es estadísticamente significativo con base en la prueba t convencional. Por supuesto, este caso es extremo.

b) En los modelos que contiene apenas dos variables explicativas, puede tenerse una idea de colinealidad relativamente buena mediante el examen del coeficiente de correlación de orden cero, o simple entre las dos variables. Si esta correlación es alta, la multicolinealidad es generalmente la culplable.

miércoles, 29 de octubre de 2014

Resumen y conclusiones Multicolinealidad y Muestras pequeñas (II)

martes, 28 de octubre de 2014

Resumen y conclusiones Multicolinealidad y Muestras pequeñas (I)

- Uno de los supuestos del modelo clásico de regresión lineal es que no haya multicolinealidad entre las variables explicativas, las X. Interpretado en términos generales, la multicolinealidad se refiere a una situación en la cual existe una relación lineal exacta o aproximadamente exacta entre la variables X.

lunes, 27 de octubre de 2014

Es la multicolinealidad necesariamente mala? Posiblemente no, si el objetivo es solamente la predicción (II)

Esto puede surgir si los coeficientes individuales resultan estar numéricamente por encima del valor verdadero, de tal forma que el efecto siga visible, a pesar de estar inflados los errores estándar y/o debido a que el valor verdadero mismo es tan grande que aun cuando se obtenga una estimación bastante subestimada, ésta continúa siendo significativa.

domingo, 26 de octubre de 2014

Es la multicolinealidad necesariamente mala? Posiblemente no, si el objetivo es solamente la predicción (I)

sábado, 25 de octubre de 2014

Otros métodos de remediar la multicolinealidad

viernes, 24 de octubre de 2014

Reducción de la colinealidad en las regresiones polinomiales

jueves, 23 de octubre de 2014

Datos nuevos o adicionales (II)

La obtención de datos adicionales o "mejores" no siempre es tan sencilla, puesto que como lo mencionan Judge et al.

Desafortunadamente, los economistas, muy pocas veces, pueden obtener información adicional sin incurrir en altos costosos y mucho menos pueden seleccionar los valores de las variables explicativas que desean. Adicionalmente, al agregar variables nuevas en situaciones que no son controladas, se debe ser cuidadoso de no agregar observaciones que fueron generadas en un proceso diferente del asociado con el conjunto original de datos; es decir, se debe estar seguros de que la estructura económica asociada con las nuevas observaciones sea igual a la estructura original.

miércoles, 22 de octubre de 2014

Datos nuevos o adicionales (I)

martes, 21 de octubre de 2014

Transformación de variables (II)

El modelo de regresión utilizando primeras diferencias reduce frecuentemente la severidad de la multicolinealidad porque, aun cuando los niveles de X2 y X3 puede estar altamente correlacionadas, no hay razón a priori para pensar que sus diferencias crea algunos problemas.

Sin embargo, la transformación que utiliza primeras diferencias crea algunos problemas adicionales. El término de error vt que aparece en (10.8.3) puede no satisfacer uno de los supuestos del modelo clásico de regresión lineal, a saber, que en las perturbaciones no están seriamente correlacionadas. Como veremos en el capítulo 12, si el ut original es serialmente independiente o no correlacionada, el término de error vt obtenido anteriormente estará, en la mayoría de los casos, serialmente correlacionado. Nuevamente, el remedio puede ser peor que la enfermedad Además, se pierde una observación debido al procedimiento de diferenciación y, por consiguiente, los grados de libertad se reducen en 1. En una muestra pequeña, ésto puede ser un factor que se debe, por lo menos, considerar. Además, el procedimiento de primeras diferencias puede no ser el adecuado en los datos de corte transversal donde no hay un ordenamiento lógico de las observaciones.

lunes, 20 de octubre de 2014

Transformación de variables (I)

Si la relación

donde vt = ut - u(t-1). La ecuación (10.8.3) se conoce como la forma en primeras diferencias porque no se está corriendo la regresión sobre las variables originales sino sobre las diferencias de los valores sucesivos de dichas variables.

domingo, 19 de octubre de 2014

Eliminación de una(s) variable(s) y el sesgo de especificación.(II)

DEl análisis anterior es claro que eliminar una variable del modelo para aliviar el problema de la multicolinealidad puede producir un sesgo de especificación. Por tanto, el remedio puede ser peor que la enfermedad en algunas situaciones porque, mientras que la multicolinealidad puede obstaculizar la estimación precisa de los parámetros del modelo, la omisión de una variable puede llevar a graves equivocaciones con respecto a los verdaderos valores de los parámetros. Recuérdese que los estimadores MCO son MELI a pesar de la presencia de multicolinealidad perfecta.

sábado, 18 de octubre de 2014

Eliminación de una(s) variable(s) y el sesgo de especificación.(I)

Sin embargo, al eliminar una variable del modelo se puede estar incurriendo en un sesgo de especificación o error de especificación. El sesgo de especificación surge de la especificación incorrecta del modelo utilizado en el análisis. Así, si la teoría económica afirma que tanto el ingreso como la riqueza deben estar incluidos en el modelo que explica el gasto de consumo, al eliminar la variable riqueza se incurrirá en un sesgo de especificación.

Aunque se estudiará el tema del sesgo de especificación en el cap 13, se obtuvo una idea general sobre éste en la sección 7.7 donde se vió que si el modelo verdadero es

viernes, 17 de octubre de 2014

Combinación de información de corte transversal y de series de tiempo (III)

jueves, 16 de octubre de 2014

Combinación de información de corte transversal y de series de tiempo (II)

Y*t = β1 + β2lnPt + ut

donde Y* = lnY - β3ln I, es decir, Y* representa ese valor de Y después de eliminarle el efecto del ingreso. Ahora se puede obtener una estimación de la elasticidad-precio β2 de la regresión anterior.

miércoles, 15 de octubre de 2014

Combinación de información de corte transversal y de series de tiempo (I)

martes, 14 de octubre de 2014

Información a priori

Cómo se obtiene información a priori? Esta puede provenir de trabajo empírico anterior, en donde el problema de colinealidad resultó ser menos grave o de la teoría relevante que soporta el campo de estudio. Por ejemplo, en la función de producción tipo Cobb-Douglas (7.10.1) si se espera que prevalezcan los rendimientos constantes a escala, entonces (β2 + β3) =1, en cuyo caso se puede efectuar la regresión (8.7.13), regresando la razón producto-trabajo sobre la razón capital-trabajo. Si existe colinealidad entre el trabajo y el capital, como generalmente es el caso en la mayor parte de la información muestral, dicha transformación puede reducir o eliminar el problema de colinealidad. Pero es preciso hacer una advertencia aquí con respecto a la imposición de esas restricciones a priori, "... puesto que en general se desea probar las predicciones a priori de la teoría económica en lugar de imponerlas simplemente sobre los datos para los cuales ellas pueden no ser ciertas" Sin embargo, se sabe, de la sección 8.7, cómo probar explícitamente la validez de tales restricciones.

lunes, 13 de octubre de 2014

Medidas remediales

domingo, 12 de octubre de 2014

Factores de tolerancia y de inflación de varianza (III)

Para concluir la discusión de detección de la Multicolinealidad, se hace énfasis en que los diversos métodos que hemos estudiado son esencialmente "expediciones de pesca", ya que no se puede decir cuáles de ellos funcionan en una aplicación particular. Sin embargo, no se puede hacer mucho al respecto, puesto que la multicolinealidad es un problema especifico de una muestra dada sobre la cual el investigador puede no tener mucho control, especialmente si los datos son no experimentales por naturaleza como es el caso común que enfrentan los investigadores en las ciencias sociales.

Nuevamente, como una parodia de multicolinealidad, Goldberger cita diversas formas de detectar la micronumerosidad, tales como el desarrollo de valores críticos del tamaño de la muestra, n* tales que la micronumerosidad es un problema solamente si el tamaño real de la muestra, n, es más pequeño que n*. El punto de la parodia de Goldberger es enfatizar que el tamaño pequeño de la muestra y la falta de variabilidad en las variables explicativas pueden ocasionar problemas que son pro lo menos tan graves como aquellos debidos a la multicolinealidad.

sábado, 11 de octubre de 2014

Factores de tolerancia y de inflación de varianza (II)

Otros autores utilizan la medida de tolerancia para detectar la multicolinealidad. Esta se define como:

El FIV (o tolerancia) como medida de colinealidad no está libre de crítica. Como lo indica (10.7.4), var (βi) depende de tres factores: σ², Σxi² y FIVj. Un FIV alto puede ser contrarrestado por un σ² bajo o una Σxi² alta. Para ponerlo de otra forma, un FIV alto no es condición necesaria ni suficiente para obtener varianzas y errores estándar altos. Por consiguiente, la alta multicolinealidad, como la mide un FIV alto, puede no necesariamente ocasionar errores estándar altos. En toda esta discusión, los términos alto y bajo son utilizados en un sentido relativo.

viernes, 10 de octubre de 2014

Factores de tolerancia y de inflación de varianza (I)

donde βi es el coeficiente de regresión (parcial) del regresor Xj, R²j es el R² en la regresion (auxiliar) de Xj sobre los restantes (k-2) regresores FIVj es el primer factor de inflación de varianza introducido en la sección 10.5. A medida que R²j aumenta hacia la unidad, es decir, a medida que aumenta la colinealidad Xj con los demás regresores, el FIV también aumenta y en el límite puede ser infinito.

jueves, 9 de octubre de 2014

Entonces se tiene esta regla práctica

Para el ejemplo ilustrativo, k = 3.0/0.00002422 o alrededor de 123,864 e IC √123864 = alrededor de 352; en consecuencia, tanto k como IC sugieren multicolinealidad severa. Claro está que k e IC pueden calcularse entre el máximo valor propio y cualquier otro valor propio, como se hace en el listado. (Nota: En el listado no se calcula explícitamente k, pero éste es simplemente IC elevado al cuadrado). A propósito, obsérvese que un valor propio bajo (en relación con el máximo valor propio) es generalmente una indicación de dependencias casi lineales en los datos.

Algunos autores consideran que el índice de condición es el mejor diagnóstico de multicolinealidad disponible. Sin embargo, esta opinión no es ampliamente aceptada. Entonces, el IC es solamente una regla práctica, quizá un poco más sofisticada. Para mayores detalles, el lector puede consultar las referencias.

miércoles, 8 de octubre de 2014

Valores propios e índice de condición

martes, 7 de octubre de 2014

Regresiones auxiliares (II)

... si la multicolinealidad comprende solamente unas pocas variables, de tal forma que las regresiones auxiliares no sufren de multicolinealidad extensa, los coeficientes estimados pueden revelar la naturaleza de la dependencia lineal entre los regresores. Desafortunadamente, si existen diversas asociaciones lineales complejas, este ejercicio de ajuste de ajuste de curva puede no tener gran valor puesto que será difícil identificar las interrelaciones separadas.

En lugar de probar formalmente todos los valores R² auxiliares, se puede adoptar la regla práctica de Klien que sugiere que la multicolinealidad puede ser un problema complicado solamente si el R² obtenido de una regresión auxiliar es mayor que el R² global, es decir, aquél obtenido de la regresión, ésta debe ser utilizada con buen criterio.

lunes, 6 de octubre de 2014

Regresiones auxiliares (I)

domingo, 5 de octubre de 2014

Examen de las correlaciones parciales

Aunque puede ser útil un estudio de correlaciones parciales, no ha garantía de que estas proporcionen una guía infalible sobre multicolinealidad, ya que puede suceder que tanto el R² como todas las correlaciones parciales sean suficientemente altas. Sin embargo y tal vez más importante, C. Robert Wichers ha mostrado que la prueba de correlación parcial de Farrar-Glauber es ineficaz en el sentido de que una determinada correlación parcial puede ser compatible con diferentes patrones de multicolinealidad. La prueba Farrar-Glauber también ha sido criticada severamente por T. Krishna Kumar, John O'Hagan y Brendan McCabe.

sábado, 4 de octubre de 2014

Altas correlaciones entre parejas de regresores

Por consiguiente, en los modelos que involucran más de dos variables explicativas, la correlación simple o de orden cero no proporcionará una guía infalible sobre la presencia de multicolinealidad. Claroestá que si solamente existen dos variables explicativas, entonces las correlaciones de orden cero serán suficientes.

viernes, 3 de octubre de 2014

Un R² elevado pero pocas razones t significativas

Aunque este diagnóstico es razonable, su desventaja es que "es demasiado fuerte, ene el sentido de que la multicolinealidad se considera dañina, únicamente cuando la totalidad de las influencias de las variables explicativas sobre Y no se pueden separar."

Estimación MCO ignorando la autocorrelación (II)

- Es probable que la varianza residual σ² = Σu²t/(n-2) subestime la verdadera σ² .

- Como resultado, es probable que se sobreestime R²

- Aun si σ² no está subestimada, var(β2) puede subestimar var(β2)ARI [ecuación 12.2.6], su varianza bajo autocorrelación (de primer orden), aun cuando está última es ineficiente comparada con var(β2)^MCG

- Por consiguiente, las pruebas de significancia t y F usuales dejan de ser válidas y, de ser éstas aplicadas, es probable que conduzcan a conclusiones erróneas sobre la significancia estadística de los coeficientes de regresión estimados.

jueves, 2 de octubre de 2014

Detección de la multicolinealidad (II)

miércoles, 1 de octubre de 2014

Detección de la multicolinealidad (I)

- La multicolinealidad es un problema de grado y no de clase. La distinción importante no es entre la presencia y la ausencia de multicolinealidad, sino entre sus diferentes grados.

- Puesto que la multicolinealidad se refiere a la condición de las variables explicativas las cuales son no estocásticas por supuestos, ésta es una característica de la muestra no de la población.

Por consiguiente, no es necesario "llevar a cabo pruebas sobre multicolinealidad" pero se puede, si se desea, medir su grado en cualquier muestra determinada.