Busca en el Blog

jueves, 31 de julio de 2014

miércoles, 30 de julio de 2014

Propiedades del vector MCO β

La prueba se da en el ápendice 9A, sección 9A.4. Como se estableció en la introducción, el caso de k variables es como en la mayoría, una extensión directa de los casos de dos y tres variables.

martes, 29 de julio de 2014

Matriz de varianza-covarianza de β (II)

lunes, 28 de julio de 2014

Matriz de varianza-covarianza de β (I)

Por definición, la matriz de varianza-covarianza de β es [cf.(9.2.2)]

domingo, 27 de julio de 2014

Una ilustración (II)

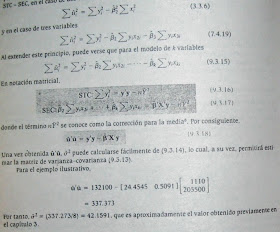

Anteriormente se obtuvo β1 = 24.4545 y β2 = 0.5091 utilizando el computador. La diferencia entre las dos estimaciones se debe a errores de aproximación. A propósito obsérvese que al trabajador con calculadora de escritorio, es esencial obtener resultados con un número significativo de digitos para minimizar los errores de aproximación.

sábado, 26 de julio de 2014

Una ilustración (I)

viernes, 25 de julio de 2014

Estimación MCO (IV)

En (9.3.10), las cantidades conocidas son (X'X) y (Xý) ( el producto cruzado entre las variables X y y) y la incógnita es β. Ahora utilizando álgebra matricial, si la inversa de (X'X) existe, es decir, (X'X)^-1, entonces premultiplicando ambos lados de (9.3.10) por esta inversa se obtiene.

La ecuación (9.3.11) es un resultado fundamental de la teoría MCO en notación matricial. Muestra la forma cómo el vector β puede ser estimado a partir de la información dada. Aun cuando (9.3.11) se obtuvo de (9.3.9), ésta puede obtenerse directamente de (9.3.7) diferenciando û'û con respecto a β.

jueves, 24 de julio de 2014

Estimación MCO (III)

miércoles, 23 de julio de 2014

Estimación MCO (II)

martes, 22 de julio de 2014

Estimación MCO (I)

donde β es un vector de columna de k elementos compuesto por lo estimadores MCO de los coeficientes de regresión y donde û es un vector columna n x 1 de n residuales.

lunes, 21 de julio de 2014

Supuestos del modelo clásico de regresión lineal en notación matricial (III)

domingo, 20 de julio de 2014

Supuestos del modelo clásico de regresión lineal en notación matricial (II)

El supuesto 3 establece que la matriz X, n x k es no-estocástica; es decir; consta de números fijos. Como se anotó anteriormente, el análisis de regresión es de regresión condicional, es decir, condicional a los valores fijos de las variables X.

El supuesto 4 establece que la matriz X tiene rango columna completo igual a k, el número de columnas en la matriz. ESto significa que las columnas de la matriz X son linealmente independientes; es decir, no ha relación lineal exacta entre las variables X. En otras palabras no hay multicolinealidad. En notación escalar esto es equivalente a decir que no existe un conjunto de números λ1, λ2, ...... λk = 0 no todos iguales a cero tales que [veáse (7.1.8)]/

sábado, 19 de julio de 2014

viernes, 18 de julio de 2014

Supuestos del modelo clásico de regresión lineal en notación matricial (I)

El supuesto 2 [ecuación (9.2.2)] es una forma compacta de expresar los dos supuestos dados en (3.2.5) y (3.2.2) bajo notación escalar. Para ver esto, se puede escribir

donde I es una matriz de identidad NxN

jueves, 17 de julio de 2014

Modelo de regresión lineal de K variables (IV)

Como en los casos de dos y tres variables, el objetivo es estimar los parámetros de la regresión múltiple (9.1.1) e inferir sobre ellos a partir de la información disponible. En la notación matricial esto equivale a estimar β y a inferir sobre ella. Para fines de estimación, se puede utilizar el método de mínimos cuadrados ordinarios (MCO) o el método de máxima verosimilitud (MV). Pero como se anotó antes, estos dos métodos producen valores estimados idénticos de los coeficientes de regresión. Por consiguiente, se limitará la atención al método de MCO.

miércoles, 16 de julio de 2014

Modelo de regresión lineal de K variables (III)

El sistema (9.1.3) es conocido como la representación matricial del modelo de regresión lineal general (de k variables). Puede escribirse en forma más compacta como

martes, 15 de julio de 2014

Modelo de regresión lineal de K variables (II)

donde y = vector columna, nx1, de observaciones sobre la variable dependiente Y.

X = matriz, n x k, que contiene n observaciones sobre las k-1 variables X2 a Xk, la primera columna de números 1 representan el término del intercepto. (Esta matriz se conoce también como la matriz de información).

β = vector columna, k x 1 de los parámetros desconocidos β1, β2, βk.

u= vector columna, nx1, de n perturbaciones ui.

lunes, 14 de julio de 2014

Modelo de regresión lineal de K variables (I)

donde β1 = el intercepto, β2 a βk = coeficientes (pendientes) parciales u= término de perturbación estocástica e i = iésima observación, siendo n el tamaño de la población. La FRP (9.1.1) debe interpretarse en la forma usual: la media o el valor esperado de Y condicionando a los valores fijos (en muestreo repetido) de X2, X3, ...... Xk, es decir, E(Y|X2i, X3i....., Xki).

domingo, 13 de julio de 2014

Enfoque matricial en el modelo de regresión lineal

Una gran ventaja del álgebra matricial sobre la escalar (álgebra elemental que trata con escalares o números reales) es que proporciona un método compacto de manejo de modelos de regresión, que involucran cualquier número de variables; una vez que el modelo de k variables ha sido formulado y resuelto en notación matricial, la solución se puede aplicar a una, dos, tres, o cualquier número de variables.

sábado, 12 de julio de 2014

Prueba de la razón de verosimilitud (RV) (III)

Para continuar con el ejemplo, utilizando la versión MICRO TSP 7.0, se obtiene la siguiente información:

FLVNR = -132.3601 y FLVR = -136.5061

Por consiguiente,

λ = 2[-132.3601 - (-136.50610)] = 8.2992

Asintóticamente, su distribución es igual a la ji cuadrado con 1 g de l (porque solamente se tiene una restricción impuesta)+. El valor p de obtener una valor ji cuadrado de 8.2992 o superior es de 0.004 aproximadamente, lo cual es una baja probabilidad. Por lo tanto se puede rechazar la hipótesis nula de que el precio d elos claveles no tenga efecto sobre la demanda de rosas, es decir, en la ecuación (8.9.3) la variable X3 debe conservarse. No es sorprendente que el valor de t del coeficiente de X3 en esta ecuación sea significativo.

Debido a la complejidad matemática de las prubas de Wald y LM no se estudiarán aquí. Pero como se anotó anteriormente, asintóticamente las pruebas de RV, Wald y LM dan respuestas idénticas; la escogencia entre una u otra prueba depende de la conveniencia computacional.

viernes, 11 de julio de 2014

Prueba de la razón de verosimilitud (RV) (II)

La ecuación (2) se conoce como la función logarítmica de verosimilitud restringida (FLVR) por haber sido estimada con la restricción de que a priori α3 es cero, mientras que la ecuación (1) se conoce como la FV logarítmica no restringida (FLVNR) por que a priori no se han impuesto restricciones sobre los parámetros. Para probar la validez de la restricción a priori de que α3 sea cero, la prueba RV produce el siguiente estadístico de prueba:

λ = 2(FLVNR - FLVR)

donde FLVNR y FLVR son, la función logarítmica de verosimilitud no restringida [ecuación (1)] y la función logarítmica de verosimilitud restringida [ecuación (2)], respectivamente. Si el tamaño de la muestra es grande, puede demostrarse que el estadístico de prueba λ dado en (3), sigue una distribución ji cuadrado (X²) con un número de g de l igual al número de restricciones impuestas bajo la hipótesis nula, 1 en el presente caso.

jueves, 10 de julio de 2014

Prueba de la razón de verosimilitud (RV) (I)

Lo mismo es cierto en el caso de la regresión múltiple. Para ilustrar, considérese la función lineal de demanda de rosas dada en la ecuación (8.9.1). análoga a la ecuación (5) del apéndice 4A, la función log-de verosimilitud para (8.9.1) puede escribirse así:

Como se indica en el apéndice 4A, al diferenciar esta función con respecto a α1, α2, α3 y σ², igualando a cero las expresiones resultantes y resolviendo, se obtienen los estimadores MV de estos parámetros: los estimadores MV de α1, α2 y α3 serán idétnticos a los estimadores MCO que ya se han dado en la ecuación (8.9.3), pero la varianza del error diferirá en que la suma residual al cuadrado (SRC) estará divida por n y no por (n-3) como en el caso de MCO.

miércoles, 9 de julio de 2014

El camino a seguir

Con este capítulo se concluyó nuestra exposición del modelo clásico de regresión lineal iniciada en el capítulo 2. Como se señalo en ocasiones, el modelo clásico está basado en algunos supuestos ideales o riguroros. Pero ha proporcionado una norma o posición estándar frente a la cual podemos juzgar a otros modelos de regresión que tratan de inyectar "realismo' relajando uno o más supuestos del modelo clásico. La labor en el restos del blog será encontrar lo que sucede si se incumple uno o más supuestos del modelo clásico. Agradaría saber qué tan "robusto" o "sólido" es el modelo clásico en el caso de que se adopten supuestos menos rigurosos. Interesaría saber, por ejemplo, lo que sucede si se incumple el supuesto de normalidad, o si se permite la presencia de heteroscedasticidad o de correlación serial o de errores de especificación.

Pero antes de dedicarse a esta investigación, en el capítulo 9 se introducirá el modelo clásico en notación matricial. Este capítulo proporiciona un resumen conveniente de los capítulos 1 al 8 y muestra además la razón por la cual el álgebra matricial es una herramienta tan útil, una vez se sale de los modelos de regresión con dos o tres variables; si se permite que con ésta se maneje el modelo de regresión con variables sería un trabajo muy desordenado.

Debe anotarse que en el capítulo 9 no es esencial para entender el resto del texto. Se ha incluido para beneficio de los estudiantes con mayor formación matemática. Sin embargo con las bases de álgebra matricial dadas en el apéndice B el lector sin conocimiento previo del álgebra matricial encontrará de utilidad estudiar el capítulo. Pero permítanme reiterar, este capítulo no es crítico para entender el resto del blog; puede ser omitido sin pérdida de continuidad.

martes, 8 de julio de 2014

La tríada de las pruebas de hipótesis: Razón de verosimilitud (RV), WALD (W) y multiplicador de Lagrange (ML)

En este capítulo y en los anteriores se han utilizado, generalmente, las pruebas t, F y ji-cuadrado para probar una diversidad de hipótesis en el contexto de los modelos de regresión líneal (en parámetros). Pero una vez se sale del mundo algo cómodo de los modelos de regresión lineal, se necesitan métodos para probar hipótesis con los que se puedan manejar modelos de regresión, lineales o no lineales.

Con la conocida triada de pruebas de verosimilitud, de Wald y del multiplicador de Lagrange, se puede lograr este propósito. Lo interesante de observar es que asintóticamente (es decir, en muestras grandes) las tres pruebas son equivalentes en cuanto a que la estadística de prueba asociada con cada una de estas pruebas sigue la distribución ji cuadrado.

Aun cuando se estudiará la Prueba de la razón de verosimilitud en el apéndice de este capítulo, en general no se utilizará este tipo de pruebas en este libro de texto por la razón pragmática de que en muestras pequeñas o finitas, que son las que, desafortunadamente, manejan la mayoría de los investigadores, la prueba F que se ha utilizado hasta ahora será suficiente. Como lo anotan Davidson y MacKinnon.

Para modelos de regresión lineal, con errores normales o sin ellos, no hay necesidad de revisar el ML, W y RV ya que al hacerlo no se gana información adicional a la contenida en F^22.

lunes, 7 de julio de 2014

Predicción con regresión múltiple (III)

Recuérdese que los g de l para el valor t es (n-3) para el modelo de tres variables, (n-4) para el modelo de cuatro variables, o (n-k) para el modelo de k variables.

domingo, 6 de julio de 2014

Predicción con regresión múltiple (II)

Sin embargo, las varianzas de Y1971 y Y1971 son diferentes. De las fórmulas dadas en el capítulo 9, puede mostrarse que:

donde se(Y1971) se obtiene de (8.10.3) y donde se supone que esta predicción está basada en los valores dados de X2 y X3 para 1971. Sobra decir, el mismo procedimiento puede repetirse para cualquier otro valor de X2 y X3.

sábado, 5 de julio de 2014

Predicción con regresión múltiple (I)

La regresión múltiple estimada también puede ser utilizada para fines similares y el procedimiento para hacerlo es una extensión directa del caso de dos variables, con excepción de las fórmulas para estimar la varianza y el error estándar de los valores de pronósotico [comparables a (5.10.2) y (5.10.6) de lo del modelo con dos variables] las cuales son más bien complejas y se manejan mejor mediante los métodos matriciales estudiados en el capítulo 9. (Véase sección 9.9).

Para ilustrar el mecanismo de la predicción media e individual, se recuerda la regresión anteriormente estimada del consumo personal para los Estados Unidos durante el periodo 1956-1970.

viernes, 4 de julio de 2014

Ejemplo Demanda de Rosas (III)

El coeficiente de Z2 es estadísticamente significativo a un nivel de significancia del 12% (el valor p es 0.1225). Por consiguiente, se puede rechazar la hipótesis de que el verdadero modelo es log-lineal a este nivel de significancia. Por supuesto, si se utilizan los niveles de significancia converncionales de 1 y 5% entonces no se puede rechazar la hipótesis de que el verdadero modelo es log-lineal. Como lo muestra este complejo, es muy posible que en una situación dada no se puedan rechazar una u otra de las especificaciones.

jueves, 3 de julio de 2014

Ejemplo Demanda de Rosas (II)

Para decidir entre estos modelos con base en la prueba MWD, se prueba primero la hipótesis de que el modelo verdadero es líneal. Luego, siguiendo el Paso IV de la prueba, se obtiene la siguiente resgresión:

Puesto que el coeficiente Z1 no es es estadísticamente significativo (el valor p del t estimado es 0.98), no se rechaza la hipótesis de que el verdadero modelo es lineal.

miércoles, 2 de julio de 2014

Ejemplo Demanda de Rosas (I)

martes, 1 de julio de 2014

Prueba de la forma funcional de la Regresión: Selección entre modelos de regresión lineal y log-lineal (II)

Paso II: Estímese el modelo log-lineal y obténgase los valores ln Y estimados; denomínense ln f (es decir, lnY)

Paso III: Obténgase Z1 = (ln Yf - ln f).

Paso IV: Efectúese la regresión de Y sobre las X y Z1 obtenida en el Paso III. Rechácese Ho si el coeficiente de Z1 es estadísticamente significativo mediante la prueba t usual.

Paso V: Obténgase Z2 = (antilog de ln f - Yf)

Paso VI: Efectúese la regresión del logaritmo de Y sobre los logaritmos de las X y Z2. Rechácese H1 si el coeficiente de Z2 es estadísticamente significativo mediante la prueba t usual.

Aun cuando la prueba MWD parece compleja, la lógica de la prueba es bastante simple. Si el modelo lineal es en realidad el modelo correcto, la variable construida Z1 no debería ser estadísticamente significativa en el paso IV, ya que en ese caso los valores Y estimados del modelo lineal y aquellos estimados del modelo log-lineal (después de obtener sus valores antilog para efectos comparativos) no deberían ser diferentes. El mismo comentario se aplica a la hipótesis alternativa H1.